5 мифов о нагрузочном тестировании, которые стоят компаниям миллионов

По данным ITIC, 90% компаний теряют свыше 300 000 долларов за каждый час простоя, а у 41% убытки достигают 1–5 миллионов. Для e-commerce-проектов это означает, что даже кратковременное падение сайта во время пиковых нагрузок может обернуться ощутимыми финансовыми потерями и снижением лояльности клиентов. Но нагрузочное тестирование по-прежнему воспринимается как дополнительная, а не обязательная мера, хотя каждый ИТ-директор компании несет ответственность не только за технологический стек, но и за управление рисками, угрожающими бизнесу. Эксперты компании Kislorod разбирают пять мифов, из-за которых компании теряют сон и деньги.

Миф 1. «Нагрузочное тестирование — это дорогая игрушка для перформанс-инженеров. ROI неочевиден»

По данным Gartner, средний час простоя обходится компаниям примерно в 300 000 долларов, а для 41% предприятий — доходит до 1–5 миллионов. Этот показатель актуален и для малого бизнеса: каждая минута недоступности сайта стоит десятки тысяч рублей прямых и косвенных потерь. Если вывести примерную формулу, то она может выглядеть так:

Потери от простоя ≈ (упущенная выручка + стоимость восстановления + штрафы по SLA + репутационные риски).

Кейс

Крупный дистрибьютор корейской косметики в России.

Во время ключевых распродаж сайт клиента регулярно «ложился» под наплывом посетителей. Пиковые нагрузки, которые должны были приносить максимальную выручку, оборачивались прямыми убытками и подрывом репутации. Архитектура сайта, созданная предыдущим подрядчиком, не была рассчитана на масштабирование.

После серии нагрузочных тестов, которые точно определили узкие места производительности и критические точки отказа системы, была проведена оптимизация кода и серверной инфраструктуры. В результате команда KISLOROD не только устранила риски сбоев, но и заложила основу для масштабирования.

Итоги:

- доход во время пиковых нагрузок вырос на 40% за счет полного устранения простоев;

- средняя конверсия сайта увеличилась на 15% благодаря стабильной и быстрой работе интерфейса;

- годовая онлайн-выручка показала рост на 22%, так как клиент смог позволить себе более дорогие рекламные кампании, не опасаясь сбоев.

Вывод

Современные инструменты нагрузочного тестирования позволяют не просто «гонять» виртуальных пользователей, а моделировать реальные бизнес-сценарии: наплыв пользователей после email-рассылки или интеграции у блогеров, сценарий «положили в корзину, но не купили», нагрузка на API мобильного приложения. Отчет предоставляется не в RPS (запросах в секунду), а в потенциально потерянных транзакциях и максимальной устойчивой нагрузке в денежном выражении.

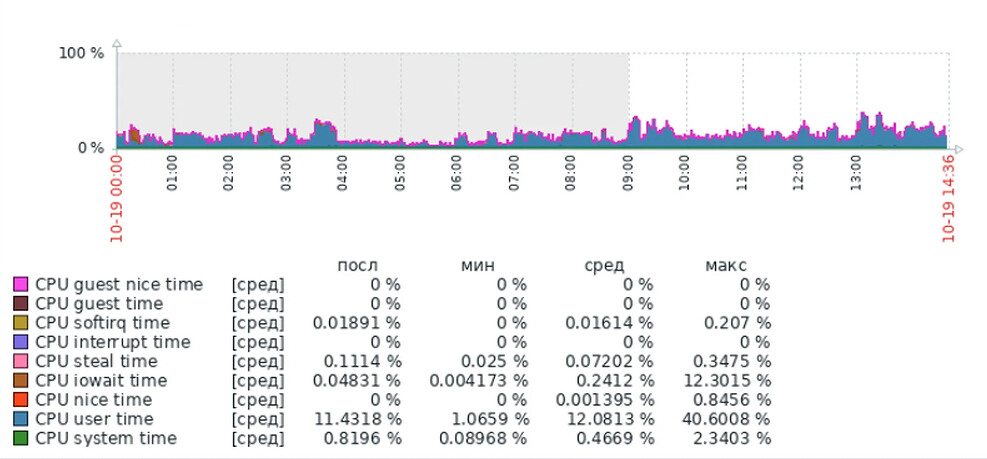

Миф 2. «Наша DevOps-команда и так следит за метриками CPU и memory»

Мониторинг показывает только симптомы, а нагрузочное тестирование выявляет саму причину. High CPU — это следствие, причина — неоптимальный запрос к базе данных, который срабатывает при 1000+ одновременных пользователей.

Кейс

Aquanet — крупнейший производитель сантехники и мебели для ванных комнат в России.

Компания столкнулась с критическими замедлениями и нестабильностью сайта, которые блокировали рост онлайн-продаж. Задача заключалась не только в точечном исправлении ошибок, но в проведении полномасштабного технического аудита для выявления фундаментальных причин сбоев.

Нагрузочное тестирование стало ключевым инструментом диагностики, которое показало, что текущая инфраструктура не выдерживает даже фоновой нагрузки от ботов, не говоря о пиках трафика.

Был проведен рефакторинг кода, оптимизирована база данных и каталог, но главное — полностью переработана серверная архитектура. Специалисты развернули систему из четырех серверов с интеллектуальной маршрутизацией трафика, которая изолировала вредоносные и просто «шумные» запросы.

Итоги:

- сайт получил запас прочности, в 5 раз превышающий пиковые плановые нагрузки;

- количество сбоев сократилось до нуля, что обеспечило стабильный рост онлайн-выручки.

Вывод

Мониторинг CPU и memory констатирует только факт проблемы, в то время как нагрузочное тестирование отвечает на вопрос «что сломается и при какой нагрузке?» до того, как это произойдет. В случае с Aquanet, пассивное наблюдение за метриками не выявило бы хрупкость архитектуры под нагрузкой, что и доказал аудит. Это позволило не просто ускорить сайт, а обеспечить ему запас прочности для обработки любых пиковых нагрузок.

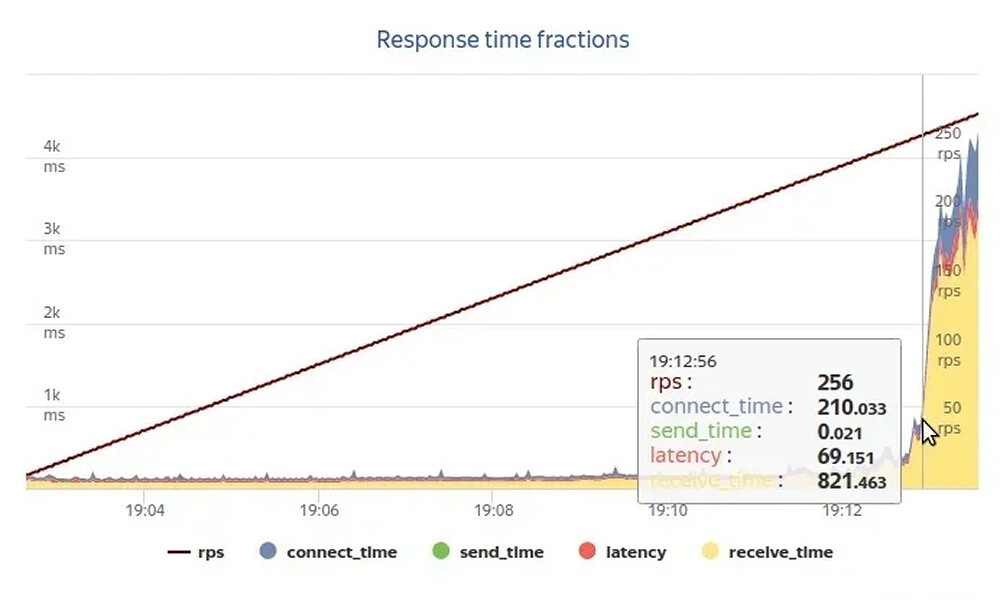

Помимо архитектурных проблем, тестирование часто выявляет технические узкие места, которые не видны при обычном мониторинге. Например, исчерпание воркеров PHP-FPM при относительно невысокой нагрузке. Когда количество одновременных процессов обработки запросов достигает лимита, новые обращения начинают скапливаться в очереди, что приводит к критическому замедлению работы всего сайта. При этом показатели загрузки процессора и памяти могут оставаться в пределах нормы, создавая ложное ощущение стабильности.

Такая ситуация особенно характерна для систем, где не настроено автоматическое масштабирование количества обрабатывающих процессов в зависимости от входящего потока запросов.

Миф 3. «Мы провели тест полгода назад после редизайна. Данные актуальны»

Кодовая база компании — живой организм. Ежедневные коммиты ломают производительность так же часто, как и функциональность.

Кейс

Розничная сеть премиальной женской одежды.

После успешного редизайна и нагрузочного тестирования через шесть месяцев сайт снова начал тормозить в ключевые периоды продаж. Админ-панель, критически важная для обработки заказов, работала с задержками до нескольких минут, парализуя работу операторов.

Проблема возникла из-за множества незаметных ежедневных обновлений: были добавлены новые интеграции с CRM, мобильным приложением и Mindbox, обновлены модули корзины и фильтров, а также внедрены десятки мелких правок. Каждое из этих изменений по отдельности не вызывало проблем, но их совокупный эффект привел к деградации производительности под нагрузкой.

Итоги:

- повторное нагрузочное тестирование выявило новые узкие места в обновленных модулях;

- в 4 раза увеличилась скорость работы админ-панели и фронтенда, что позволило без сбоев проводить масштабные распродажи.

Вывод

Регулярные обновления могут создавать скрытые проблемы с производительностью диска. Системы часто начинают чрезмерно обращаться к файлам на жестком диске для операций, которые могли бы кэшироваться в оперативной памяти. Например, загрузка конфигурационных файлов или баз геоданных при каждом запросе вместо однократной инициализации.

Когда код постоянно считывает одни и те же данные с диска, это создает избыточную нагрузку на дисковую подсистему и процессор. Перенос таких операций в память или использование специализированных решений для кэширования позволяет кратно сократить время обработки запросов и снизить нагрузку на инфраструктуру.

Миф 4. «Главная цель — узнать, сколько пользователей выдержит система»

Не упасть — недостаточно. Цель — деградировать предсказуемо, соблюдая SLO. Пользователям неважно, выдержали вы 10K или 100K RPS. Им важно, чтобы заказ прошел, а страница загрузилась за 2 секунды.

Кейс

Популярный сервис онлайн-бронирования отелей и авиабилетов

Компания столкнулась с серьезными репутационными и финансовыми потерями не из-за полного отказа системы, а из-за ее непредсказуемой деградации. Время обработки платежей и подтверждения брони выросло с 5 секунд до 4 минут. Формально сайт был доступен, пользователи могли искать отели и заполнять данные, но на критическом этапе оплаты система зависала.

Это привело к тысячам не завершенных бронирований, массовым отказам в пользу конкурентов и ущербу, оцениваемому более чем в 20 млн рублей за день. Стандартные нагрузочные тесты, которые проводились ранее, проверяли только факт доступности интерфейса, но не гарантировали выполнение бизнес-транзакций в установленные сроки.

Итоги:

- кардинально изменили стратегию тестирования, начав проверять не просто количество одновременных сессий, а гарантированную пропускную способность по ключевым бизнес-процессам — поиску, бронированию и оплате;

- внедрили механизмы приоритизации, которые в условиях пиковой нагрузки автоматически резервируют вычислительные ресурсы для критически важных операций, таких как финальное подтверждение брони;

- добились предсказуемой деградации: даже при 5-кратном превышении нормальной нагрузки скорость выполнения платежных операций не превышает 15 секунд.

Вывод

Ошибочно полагать, что основная задача нагрузочного тестирования — найти момент, когда система перестанет отвечать. Гораздо важнее убедиться, что в условиях предельной нагрузки критически важные для бизнеса функции продолжают работать в рамках заданных стандартов обслуживания.

Миф 5. «Мы протестируем, когда будем готовы к релизу новой фичи»

Тестирование в конце цикла разработки — самый дорогой и рискованный способ искать проблемы. Обнаружение сбоя за неделю до релиза заставит либо перенести запуск, либо выкатиться с уязвимостью.

Кейс

Крупный онлайн-гипермаркет спортивных товаров для велосипедистов и экипировки.

Проект ежесезонно сталкивался с одной и той же проблемой — административная панель, через которую операторы обрабатывали заказы, полностью зависала во время сезонных продаж, страницы грузились минутами вместо секунд. Проблема была заложена на архитектурном уровне — админка использовала те же ресурсы БД, что и публичная часть сайта, а нагрузочное тестирование всегда проводилось в конце разработки и только для фронтенда.

Итоги:

- внедрили практику Shift-Left Performance Testing;

- провели архитектурные assessment-сессии с разработчиками, которые получили легкие инструменты для проверки производительности на каждый коммит;

- выявили и устранили узкое место с изоляцией БД для админки до начала кодинга, а не за неделю до запуска распродажи.

Вывод

Если откладывать нагрузочное тестирование на конец цикла, цена ошибки становится запредельной. Идеальный подход к тестированию производительности — это его интеграция на самых ранних этапах разработки, еще до написания основного кода. Такая методология, известная как Shift-Left, позволяет выявлять архитектурные недостатки на стадии проектирования, когда их исправление требует минимальных затрат.

В продвинутых командах проверка производительности встраивается непосредственно в процессы непрерывной интеграции: каждое изменение кода автоматически проходит базовое тестирование на специальном окружении, идентичном продакшену. Это превращает контроль производительности из экстренной меры в естественную часть процесса разработки, подобно автоматическим юнит-тестам или ревью кода, экономит бюджеты и нервы.

Резюме

Если говорить просто, то отказ от современного нагрузочного тестирования — это осознанное решение рисковать деньгами. Потому что каждый сбой системы — это прямые финансовые потери. Качественное нагрузочное тестирование требует комплексного подхода. Недостаточно просто создать нагрузку — необходимо правильно настроить системы мониторинга, которые будут фиксировать все критические метрики: от загрузки процессора и памяти до времени выполнения запросов к базе данных.

Без грамотно выстроенного мониторинга клиент получит лишь поверхностную картину, упустив реальные узкие места системы. Современные инструменты позволяют отслеживать сотни параметров одновременно и строить детальные графики зависимости производительности от нагрузки, но их эффективность напрямую зависит от качества первоначальной настройки и понимания архитектуры тестируемой системы.

Помимо финансового аспекта, регулярное тестирование влияет и на нематериальные показатели — доверие клиентов, репутацию бренда и эффективность маркетинговых кампаний. Потерянные пользователи почти никогда не возвращаются, поэтому инвестиция в устойчивость — это не только защита оборота, но и вклад в долгосрочную лояльность.

Что это дает на практике?

- Финансовый радар. Позволяет увидеть слабые места системы до того, как они приведут к убыткам во время распродажи или рекламной кампании.

- Постоянный контроль. Это не разовая акция, а часть ежедневного процесса разработки, как код-ревью или автоматические тесты. Так мы обеспечиваем стабильность после каждого обновления.

- Уверенность в бизнес-планах. Компании могут запускать масштабные маркетинговые акции, точно зная, что сайт их выдержит.

- Проверка архитектуры. Специалисты проверяют, будет ли новая функция или интеграция работать стабильно до того, как она попадет к пользователям.

С чего можно начать?

Вместо разового теста эксперты предлагают начать с консультации, провести обзор архитектурных рисков, которые могут привести к сбоям. Главный вопрос не в стоимости нагрузочного тестирования, а в цене, которую вы можете заплатить за его отсутствие. Разбор кейса в агентстве Kislorod поможет выявить риски и рассчитать стоимость отказоустойчивости.

■ Рекламаerid:2W5zFGfFmyrРекламодатель: ООО «КИСЛОРОД ДИДЖИТАЛ»ИНН/ОГРН: 7300000950/1227300004667Сайт: https://o2k.ru/

Поделиться

Поделиться